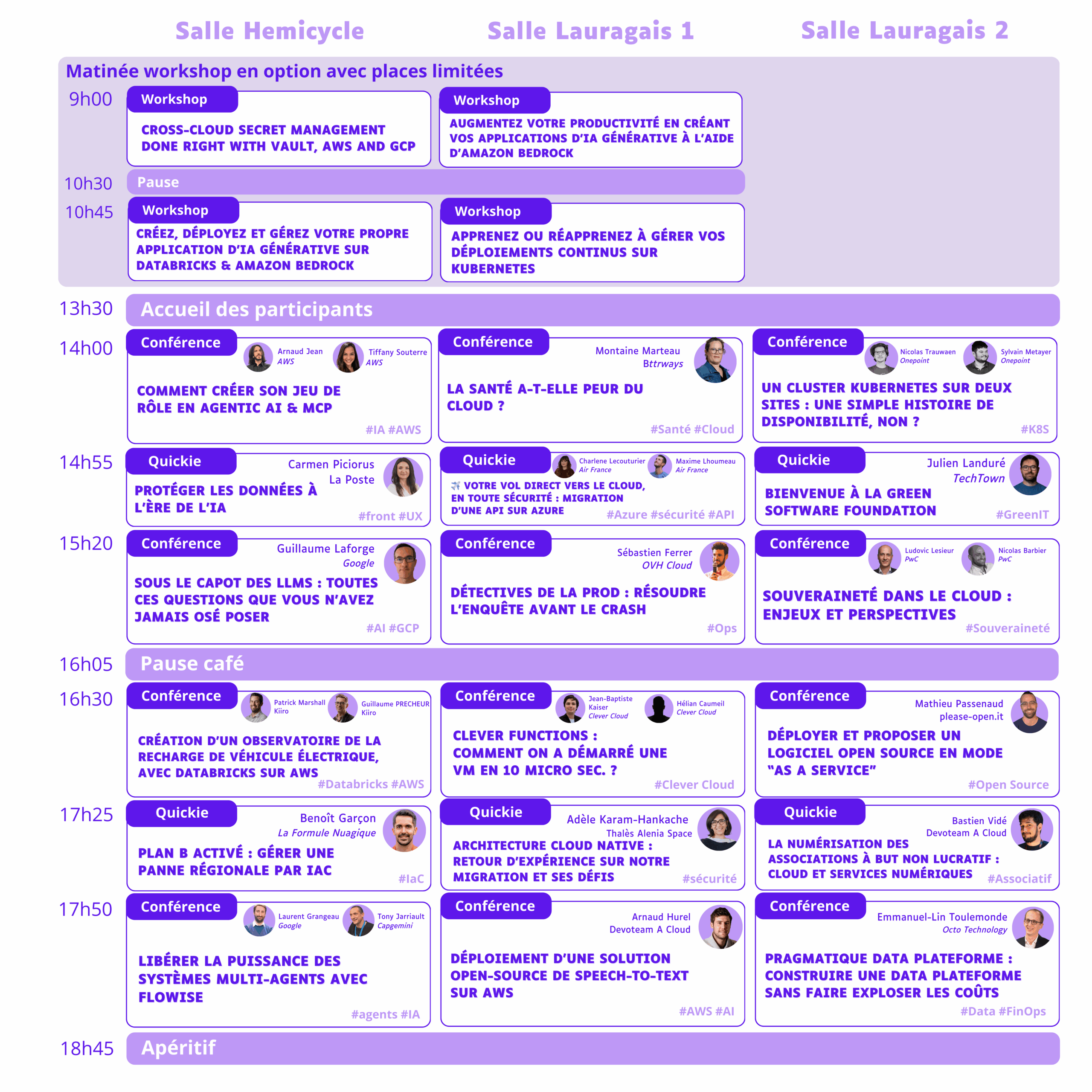

14 h – Hémicycle

Comment créer son jeu de rôle en Agentic AI & MCP

Arnaud JEAN – Tiffany Souterre

Conférence

Vous êtes un Développeur ou une Développeuse, fan de Jeu de Rôle et aimez les chats ? Alors venez découvrir Cats’ Tail, un Jeu de Rôle transformant des concepts complexes d’IA en une expérience de jeu immersive et évolutive !

Durant ce talk, vous découvrirez comment mettre en oeuvre les techniques d’Agentic AI afin de créer un Maître du Jeu (MJ) orchestrant plusieurs agents, chacuns spécialisé dans une tâche particulière.

En Bonus : Enrichir l’expérience en persistant les échanges entre joueurs et MJ dans une base de données afin de renforcer l’immersion des joueurs et joueuses :)

14 h 55 – Hémicycle

Protéger les données à l’ère de l’IA

Carmen Piciorus

Quicky

Bloquer les accès aux solutions d’IA externes par peur de fuite de données est-ce vraiment une solution ? A l’ère de l’IA, comment protéger les données confidentielles et le savoir-faire des entreprises ? L’OWASP, l’ANSSI mettent en garde sur les risques de fuite de données sans vraiment fournir les solutions.

Dans un monde où les données sont le trésor le plus précieux des entreprises, comment les équipes de cybersécurité vont continuer à assurer la confidentialité des données?

A La Poste, on pense qu’il faut plutôt apporter des solutions que de bloquer les accès. Les solutions autour de LLM Guard et Presidio nous aident à anonymiser les données et à en tirer profit des IAs, assurant que les données sensibles restent hors de portée des cybercriminels. LLM Guard permet de rajouter des contrôles sur les prompts d’entrée mais aussi sur les réponses des IAs, en protégeant ainsi contre les attaques type prompt injection et on peut même construire nos propres règles pour compléter.

Je vous propose aussi une démo de Presidio sur comment anonymiser les données et comment détecter des données sensibles dans des images générées à partir d’une IA.

15 h 20 – Hémicycle

Sous le capot des LLMs : toutes ces questions que vous n’avez jamais osé poser

Guillaume Laforge

Conférence

Les grands modèles de langage (LLM) ont pris d’assaut le monde, alimentant des applications allant des chatbots à la génération de contenu. Pourtant, sous le capot, ces modèles restent énigmatiques.

Cette présentation plongera dans les recoins cachés de la technologie des LLMs qui laissent souvent les développeurs perplexes. Il est temps de poser ces questions que vous n’avez jamais osé poser sur les mystères à la base des LLMs !

Voici quelques questions auxquelles nous répondrons :

- Vous vous demandez pourquoi les LLM crachent des tokens au lieu de mots ? D’où viennent ces tokens ?

- Pourquoi ne sont-ils pas toujours très intelligents en mathématiques ?

- Quelle est la différence entre un modèle « fondamental » / « pré-entraîné » et un modèle « fine-tuné » ?

- Comment un modèle sait-il quand il a fini de répondre à votre question ?

- Nous ajustons souvent des hyperparamètres comme la température, top-p, top-k, mais savez-vous vraiment comment ils affectent le choix des tokens ?

- La quantification rend les modèles plus petits, mais que sont tous ces encodages numériques comme fp32, bfloat16, int8, etc. ?

- Les LLM sont bons en traduction, n’est-ce pas ? Parlez-vous aussi le langage Base64 ?

Nous réaliserons ensemble que les LLM sont loin d’être parfaits :

- Nous avons tous entendu parler d’hallucinations, ou devrions-nous dire de confabulations ?

- Avez vous entendu parler de la “reversal curse” qui fait que les LLM ignorent certains faits d’un point de vue différent ?

- On pourrait penser que les LLM sont déterministes à basse température, mais vous seriez également surpris de voir comment le contexte influence les réponses des LLM…

Attachez vos ceintures, il est temps de dissiper la magie des LLM et de poser ces questions que nous n’avons jamais osé poser !

16 h 30 – Hémicycle

Création d’un Observatoire de la recharge de véhicule électrique, avec Databricks sur AWS

Patrick Marshall – Guillaume Precheur

Conférence

L’Avere-France est l’association nationale pour le développement de la mobilité électrique, et a pour objectif de faire la promotion de l’utilisation des véhicules électriques et hybrides rechargeables. Le versement des subventions et primes liées à l’installation de points de charge pour VE étant conditionné à la déclaration des données de charge, l’Avere est amenée à collecter, agréger et capitaliser sur ces données, afin de publier différentes études: baromètre de la recharge, des immatriculations, de la recharge en copropriété, du marché du véhicule d’occasion.

Nous vous présenterons comment Kiiro a accompagné l’Avere dans la création de cet observatoire en mettant en place une plateforme de données sur Databricks et AWS, dotée de fonctionnalités d’ingestion, de qualité, et de visualisation, de façon à automatiser la production de rapports réguliers sur l’activité, ainsi que publier les données elles-mêmes en open data.

17 h 25 – Hémicycle

Plan B activé : gérer une panne régionale par IaC

Benoît Garçon

Quicky

Imaginez un instant : il est 3 heures du matin, votre infrastructure cloud fonctionne parfaitement, vos applications tournent sans accroc. Soudain, une panne régionale survient, rendant une partie de vos services inaccessibles. Comment réagir ? Comment garantir la continuité de vos opérations face à une telle situation ?

Dans ce talk de 15 minutes, nous explorerons comment structurer votre Infrastructure as Code (IaC) pour assurer sa résilience face aux pannes régionales. Nous nous appuierons sur des outils tels que Terraform et Terragrunt pour mettre en place une architecture capable de s’adapter rapidement aux imprévus.

Points clés abordés :

- Compréhension des pannes régionales : Analyse des causes potentielles et de leurs impacts sur les infrastructures cloud.

- Organisation modulaire par région : Mise en place de modules Terragrunt spécifiques à chaque région pour une gestion isolée et flexible.

- Gestion des états Terraform : Séparation des états par région afin de minimiser les risques lors des déploiements et des mises à jour.

- Scénarios de basculement : Démonstration de la désactivation d’une région et du basculement automatique vers une autre, sans interruption significative des services.

À travers des exemples concrets et des démonstrations pratiques, vous découvrirez comment anticiper les pannes régionales et adapter votre IaC en conséquence. L’objectif est de vous fournir des stratégies efficaces pour maintenir la disponibilité de vos services, même en cas de défaillance majeure.

17 h 50 – Hémicycle

Libérer la puissance des systèmes multi-agents avec Flowise

Laurent Grangeau – Tony Jarriault

Conférence

De nombreux développeurs et équipes produits utilisent aujourd’hui des agents d’IA générative pour les aider à créer des logiciels ou des applications. Mais ces applications sont souvent uniquement composées d’une seule IA et ne permettent pas de réaliser des tâches complexes.

Les systèmes multi-agents offrent une approche pour modéliser des appels d’agents spécialisés capables d’interagir entre eux.

Dans cette présentation, nous explorerons les fondements de ces systèmes, en détaillant leurs composants clés et leurs modes d’interaction. Nous nous pencherons ensuite sur les différentes architectures possibles, depuis les systèmes centralisés jusqu’aux systèmes entièrement décentralisés.

Enfin, nous mettrons en œuvre une application au travers de Flowise, une plateforme open-source low code pour faciliter le développement et le déploiement de systèmes multi-agents et sa capacité à les orchestrer de manière efficace. À travers une démonstration concrète, nous verrons comment Flowise permet de créer des applications complexes, en gérant la coordination, la communication et la prise de décision entre de multiples agents.

14 h – Lauragais 1

La santé a-t-elle peur du cloud ?

Montaine Marteau

Conférence

Les données de santé sont parmi les plus convoitées sur le dark web, juste derrière les données bancaires. Surprenant ? Pas vraiment quand on connaît leur valeur. Mais alors, comment les exploiter tout en les protégeant ?

En 20 ans de MedTech, j’ai touché à la donnée de santé de différentes façons : d’abord product manager en radiothérapie pour faciliter sa saisie, puis évoluant jusqu’à CTPO d’une startup qui aide la recherche à exploiter ces données hors des murs de l’hôpital. Je vais partager avec vous mon expérience du terrain.

Au programme :

1- Le RGPD appliqué au médical (promis, ce sera digeste)

2- La collecte et structuration des données (spoiler : on est encore loin du tout automatisé)

3- Le Federated Learning en action (quand l’IA vient aux données)

4- De l’hébergement HDS à l’European Health Data Space (et ça, c’est pour demain)

Alors, le cloud dans la santé, on y va ou pas ?

14 h 55 – Lauragais 1

✈️ Votre vol direct vers le cloud, en toute sécurité : Migration d’une API sur Azure

Charlene Lecouturier – Maxime Lhoumeau

Quicky

Comment migrer en toute sécurité une API utilisée quotidiennement par des milliers d’utilisateurs vers le cloud, tout en assurant une collaboration fluide entre deux compagnies aériennes ?

Dans ce talk, nous partagerons l’expérience d’Air France et KLM dans cette transformation, en adoptant une approche cloud-native sur Azure, tout en intégrant des principes clés de sécurité, d’automatisation et de gouvernance commune.

À travers ce retour d’expérience concret, nous verrons comment nos équipes ont travaillé pour faire évoluer une API Java Spring Boot d’une infrastructure traditionnelle vers une plateforme Azure mutualisée, avec un focus sur :

✅ Une gouvernance commune de la sécurité : gestion des secrets, conformité et monitoring dans un cadre partagé entre les deux compagnies.

✅ L’automatisation des déploiements grâce à GitHub Actions, facilitant la collaboration entre nos équipes IT.

✅ Les bonnes pratiques et défis rencontrés pour garantir une transition efficace et sans rupture de service.

✅ Mutualisation des outils entre nos deux entités

Que vous soyez développeur, architecte ou simplement curieux, venez découvrir comment Air France-KLM a relevé ce défi, en harmonisant ses processus tout en garantissant un atterrissage en douceur… et en toute élégance !

15 h 20 – Lauragais 1

Détectives de la prod : résoudre l’enquête avant le crash

Sébastien Ferrer

Conférence

Saviez-vous que, derrière les coulisses de vos outils de travail, se cachent des équipes prêtes à intervenir à tout moment ?

Ces équipes, souvent discrètes mais essentielles, gèrent des dizaines de projets avec des effectifs réduits.

Mais quand une alerte survient, elles doivent réagir vite. Très vite.

Comment réussir à diagnostiquer et résoudre un incident en pleine production, sans perdre une précieuse seconde ?

Dans ce talk je vous emmène au cœur de l’action, où je partage notre méthodologie pour transformer chaque crise en une enquête méthodique et efficace.

Nous explorerons comment des outils bien pensés, une organisation affûtée, et un soupçon d’intuition transforment la gestion d’incidents en une véritable enquête… parfois aussi palpitante qu’une partie de Cluedo.

Au programme : bonnes pratiques de troubleshooting, logging et monitoring, pour que vous repartiez avec des clés concrètes pour dompter les incidents dans vos propres projets.

Vous verrez qu’en production, chaque problème cache une histoire… à résoudre en équipe.

16 h 30 – Lauragais 1

Clever Functions : comment on a démarré une VM en 10µs ?

Jean-Baptiste KAISER – Hélian CAUMEIL

Conférence

Avoir de l’auto-scaling c’est bien, pouvoir scale to 0 c’est encore mieux. Pour ça, il y a les Cloud Functions.

Les deux approches usuelles pour faire des Cloud Functions sont, d’un coté les containers et de l’autre les runtime JavaScript.

Chez Clever Cloud, nous tenons à garantir une isolation complète des workloads entre les différents clients.

C’est pourquoi nous avons développé une solution qui permet à la fois de garantir la sécurité, la haute disponibilité et la performance, le tout quelque soit le langage et sans vendor lock-in !

Tout d’abord, nous avons donc le plaisir de vous présenter le WSR : WASM SVM Runtime, une technologie de virtualisation d’un runtime WASM.

Nous allons ensuite explorer ensemble les défis techniques posés par la virtualisation d’un système entièrement fait-main, capable de démarrer en moins de 10µs.

En particulier :

- L’utilisation de la virtualisation hardware sous Linux, avec KVM.

- La compilation en WASM du code source client.

- La gestion des interfaces entre la VM et son environnement.

Enfin nous verrons comment tout ceci est possible en utilisant des standards ouverts.

17 h 25 – Lauragais 1

Architecture Cloud Native – Retour d’expérience sur notre migration et ses défis

Adele Karam-Hankache

Quicky

Dans un monde où la technologie évolue rapidement, adopter une architecture cloud native est essentiel pour optimiser l’efficacité des systèmes. Ce quickie explore les principes fondamentaux du cloud native, avec un focus sur l’architecture microservices. Contrairement à un simple déploiement sur le cloud, le cloud native repose sur une conception axée sur l’agilité, la résilience et une scalabilité dynamique.

Nous partagerons un retour d’expérience sur la réarchitecture de notre chaîne de traitement d’images, où nous avons transformé un module monolithique en une architecture microservices adaptée au cloud. Cette démarche nous a permis de remplacer 60 % du code legacy, d’améliorer la maintenabilité du système, d’augmenter la performance et de simplifier la gestion des workflows. Nous détaillerons les bénéfices obtenus en termes de réactivité, flexibilité et réduction des coûts opérationnels, tout en abordant les défis rencontrés et les leçons apprises durant cette transition.

17 h 50 – Lauragais 1

Déploiement d’une solution open-source de Speech-to-Text sur AWS

Arnaud HUREL

Conférence

Dans un monde où la vitesse de l’information est cruciale, les journalistes doivent rapidement transformer des contenus audio en textes exploitables pour la recherche documentaire et la rédaction d’articles. Ce talk vous emmène à travers le processus de mise en production d’un algorithme open source de Speech-to-Text (Whisper), déployé sur AWS à l’aide d’Amazon ECS (Elastic Container Service).

Vous découvrirez comment l’intégration de cette solution permet d’améliorer la qualité de la transcription de fichiers audio en texte, améliorant ainsi l’efficacité des journalistes dans leur travail quotidien.

Nous aborderons les défis techniques rencontrés lors du déploiement, les choix d’architecture cloud, et les meilleures pratiques pour garantir une performance optimale. Que vous soyez développeur, data scientist ou professionnel des médias, ce talk vous fournira des insights pratiques sur l’implémentation d’une solution cloud-native pour le traitement automatique de la parole.

14 h – Lauragais 2

Un cluster Kubernetes sur deux sites : une simple histoire de disponibilité, non ?

Nicolas TRAUWAEN – Sylvain METAYER

Conférence

Vous êtes en charge de mettre en place et maintenir un cluster Kubernetes. Il faut de la haute disponibilité. Vous n’avez que deux sites géographiques pour l’assurer.

Quoi ? Les recommandations parlent de trois sites ?

Ça fait des années qu’on fait de la redondance avec deux sites, au diable les recommandations ! Ça va bien se passer.

A travers nos expériences, découvrons ensemble les problèmes rencontrés, les solutions envisagées et mises en œuvre, tant au niveau administration du cluster, qu’au niveau applicatif.

14 h 55 – Lauragais 2

Bienvenue à la Green Software Foundation

Julien Landuré

Quicky

Nous parlons beaucoup de démarche d’éco-conception, de « sustainability » dans le monde Tech ces dernières années.

Ça tombe bien, la « Green Software Foundation » est une des dernières fondations filles de la Linux Foundation.

Fondé en 2021, cette fondation tente de réunir les acteurs de la Tech pour partager une vision commune et des actions déclinables.

Qui y participe à cette initiative ? Y-a-t-il déjà des actions en cours ?

C’est quoi la différence entre FinOps et GreenOps ?

Venez découvrir comment partager les bonnes pratiques autour de l’éco-conception grâce à la GSF.

15 h 20 – Lauragais 2

Souveraineté dans le Cloud: Enjeux et Perspectives

Nicolas Barbier – Ludovic Lesieur

Conférence

Dans un contexte où la souveraineté numérique devient une préoccupation majeure, le concept de Cloud de Confiance

émerge comme solution stratégique pour les entreprises et les institutions publiques.

Cette conférence traitera les enjeux liés à la souveraineté dans le cloud, en mettant en avant les défis de conformité, de sécurité et de contrôle des données, tout en

soulignant les exigences en matière d’audit et de gestion des risques cloud.

Nous discuterons également des implications des régulations et standards tels que RGPD, NIS2, SecNumCloud et DORA dans la mise en œuvre de ces solutions.

Nous explorerons comment le cloud de confiance peut aider les organisations à profiter de l’agilité et de l’efficacité du

cloud tout en assurant la protection et la souveraineté de leurs données, particulièrement dans les secteurs sensibles tels que la

santé et les services financiers. L’intégration du cloud dans la stratégie d’entreprise devient désormais indispensable pour être

compétitif, grâce aux opportunités qu’il apporte en termes de croissance, d’innovation, de flexibilité et de résilience.

Nous présenterons également des cas d’usage concrets et aborderons les stratégies adoptées par les équipes de PwC

France à Toulouse pour soutenir les acteurs locaux, nationaux et européens dans leur transition vers des solutions cloud

respectant les exigences réglementaires et de souveraineté.

16 h 30 – Lauragais 2

Déployer et proposer un logiciel open source en mode “as a service”

Mathieu Passenaud

Conférence

Les fournisseurs de services “cloud” ont déployé et déploient toujours des technologies à forte valeur ajoutée, parfois propriétaires mais aussi basées sur des technologies open source qui sont devenues des standards de marché.

Qu’est ce qui fait la valeur d’un produit basé sur une technologie open source déployé en mode “as a service” ? Qu’est-ce que vous achetez quand vous souscrivez à une base de données “managée” ou une machine virtuelle ?

En utilisant Keycloak comme exemple, nous allons voir ensemble la galaxie de services à apporter autour du produit, mais aussi les automatisations, outils, documentation et même jusqu’à la facturation afin de construire une offre répondant à des besoins et des attentes du marché du “as a service”.

17 h 25 – Lauragais 2

La numérisation des associations à but non lucratif : Cloud et services numériques

Bastien VIDÉ

Quicky

Les associations à but non lucratif sont souvent confrontées à des défis liés à leur petite taille et à leurs limites financières, les poussant dans un retard numérique important. Dans ce contexte, la transition numérique devient une opportunité cruciale pour améliorer leur efficacité opérationnelle et atteindre leurs objectifs. Cette présentation explore comment le cloud et ses différents services peut aider ces organisations à effectuer cette transition.

Nous examinerons spécifiquement les initiatives des entreprises de cloud (Google, Microsoft, Amazon, etc.) pour soutenir les associations à but non lucratif, notamment les programmes de mécénat, de soutien, les offres de services gratuits ou réduits, ainsi que les possibilités d’accès à des compétences et des connaissances spécialisées. En outre, nous présenterons les exemples concrets de réussite d’associations qui ont déjà bénéficié du cloud pour améliorer leur efficacité et atteindre leurs objectifs.

Cette présentation vise à sensibiliser les décideurs et les professionnels des associations à but non lucratif aux opportunités offertes par le cloud, ainsi qu’à encourager l’adoption de solutions numériques pour améliorer leur impact social.

17 h 50 – Lauragais 2

Pragmatique data plateforme : construire une data plateforme sans faire exploser les coûts

Emmanuel-Lin Toulemonde

Conférence

💰 « Pourquoi ma data plateforme coûte 10 fois plus cher que celle d’un autre client ? »

💸 « Nos coûts de licence ont explosé ! »

Ces verbatims de clients résument un problème devenu trop courant : toutes les organisations construisent leur data plateforme, mais à quel prix ? L’empilement technologique et la quête du « state of the art » finissent souvent par faire flamber les coûts d’infrastructure et de licences, parfois sans réelle justification.

Depuis 2 ans, avec une équipe de 3 développeurs, nous avons construit et maintenons une data plateforme qui traite plusieurs To de données chaque mois, supporte une quarantaine de cas d’usage… pour moins de 2 000€/mois de coûts cloud.

🚀 Comment est-ce possible ?

Ce talk est un retour d’expérience sur nos choix d’architecture, notre organisation et notre approche pragmatique : une data plateforme qui fait le job, sans superflu ni dépenses inutiles.